Jack Phillips ist bekannt als Experte für das Thema ‚Return on investment‘ im Bereich Training und Personalentwicklung. Er ist Gründer des „ROI-Institute“ und sein erstes Buch, „Return on investment in training and performance improvement“, in dem er seine „ROI-Methodologie“ entwickelt, datiert von 1997. Gemeinsam mit Rebecca Ray, einer Expertin im Bereich Führungskräfteentwicklung, haben Jack Phillips und Patricia Pulliam Phillips kürzlich ein Buch zum Thema Erfolgsbestimmung in der Führungskräfteentwicklung veröffentlicht. Das Buch gliedert sich in zwei Teile: (1) Erfolgsmessung in der Führungskräfteentwicklung und (2) Fallstudien zur ROI-Bestimmung.

Im ersten Teil des Buches stellen die Autoren zunächst die aktuelle Bedeutung von und Erfolgsfaktoren für Führungskräfteentwicklung heraus. Sie betonen, dass Erfolgsmessungen bei Programmen zur Führungskräfteentwicklung nicht nur möglich sind, sondern dass die Mehrzahl der CEOs grosser Unternehmen an entsprechenden Resultaten interessiert ist. Allerdings zeigen die Ergebnisse einer Befragung der Autoren unter mehr als 350 Führungskräfte-Entwicklern aus 2011, dass ROI-Bestimmungen lediglich bei ca. 11% der Programme umgesetzt werden.

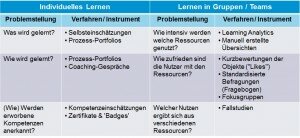

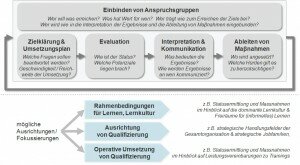

In der Folge stellen die Autoren dann das bereits aus anderen Publikationen (z.B. dem Buch „The value of learning“ von 2007) bekannte ROI Prozessmodell vor (vgl. Abbildung) und Entscheidungskriterien dazu, ob für ein konkretes Entwicklungsprogramm eine ROI-Analyse sinnvoll ist oder nicht.

Im Hinblick auf das Aufzeigen von ‚business impact‘ bei FK-Entwicklungsprogrammen plädieren die Autoren dafür, an Stelle von allgemeinen Kenngrössen (beispielsweise Umsatz pro Mitarbeiter, Stückkosten, Fehlerquote, Personalfluktuation oder Zufriedenheit mit dem Arbeitsplatz) spezifischere Kenngrössen aus den (in der Regel unterschiedlichen) Geschäftsbereichen der Teilnehmenden zu verwenden. Hierzu müssen die Teilnehmenden vorab zwei oder drei Kenngrössen definieren, auf die sie selbst Einfluss haben und die sie mit Hilfe der im Entwicklungsprogramm entwickelten Kompetenzen verbessern können. Dass dabei zahlreiche Erfolgskenngrössen zusammen kommen stellt kein Problem dar, denn die einzelnen Erfolgsmasse werden jeweils in monetäre Werte umgerechnet und können dann für die Gesamtbewertung des Programms zusammengezogen werden.

Auf ein Kapitel zur Fragen der Datenerhebung folgt ein Kapitel dazu, wie die Effekte von Entwicklungsprogrammen isoliert werden können. Hier werden die bereits bekannten Verfahren (Kontrollgruppen, Trendanalyse und Schätzungen – durch die Teilnehmenden selbst, deren Vorgesetzte oder externe Experten) aufgeführt. Allerdings bleibt offen, wie die zuerst genannten Verfahren bei funktionsübergreifenden Entwicklungsprogrammen (‚cross functional management training‘) konkret umgesetzt werden können. Die beiden Folgekapitel behandeln die Konversion der beobachteten Effekte in monetäre Werte sowie die Bestimmung der Kosten von Führungskräfteentwicklungsprogrammen und die Kalkulation des ROI. Zwei weitere Kapitel befassen sich mit der Bestimmung von nicht in Geldwerte konvertierbaren Auswirkungen von Programmen zur Führungskräfteentwicklung (‚intangible benefits‘ – Mitarbeiterzufriedenheit, Organisationsklima, Innovationsfähigkeit, Kundenzufriedenheit, etc.) und mit der Kommunikation von Ergebnissen. Prinzipiell, so die Autoren, können alle Effekte eines Entwicklungsprogramms in monetäre Werte konvertiert werden. Die Frage ist allerdings, (1) ob der dafür erforderliche Arbeitsaufwand vertretbar ist und (2) ob die Adressaten das Ergebnis akzeptieren werden. Können diese Fragen nicht mit „ja“ beantwortet werden, ist es sinnvoller, diese – bei Führungskräfteentwicklungsprogrammen häufig sehr wichtigen – Aspekte zwar systematisch zu beobachten und Ergebnisse zu berichten, nicht aber in einer ROI-Kalkulation zu berücksichtigen. Im Hinblick auf die Kommunikation der Ergebnisse stellen die Autoren heraus, dass diese sorgfältig geplant und zielgruppenspezifisch gestaltet sein muss und sie liefern einen Strukturvorschlag für einen Bericht zu einer ROI-Analyse. Im letzten Kapitel des ersten Buchteils weisen die Autoren auf typische Widerstände gegen die Umsetzung von ROI-Analysen und damit verbundene Veränderungen hin. Sie argumentieren für eine pragmatische Umsetzung und die Einbindung weiterer Beteiligtengruppen neben dem L&D-Bereich (z.B. Linienbereiche und Linienverantwortliche oder auch Controlling-Bereiche) in die Umsetzung.

Den zweiten Teil des Buchs bilden drei Fallstudien zur ROI-Bestimmung von Führungskräfteentwicklung, die in ähnlicher Form bereits in anderen Büchern der Autoren veröffentlicht waren. Gegenstand der ROI-Analysen sind:

(1) ein Coaching-Programm zur Verbesserung von Effizienz, Kundenzufriedenheit und Umsatz für Führungskräfte einer Hotelkette;

(2) ein viertägiges Trainingsprogramm (zuzüglich vorbereitendes Selbststudium) zur Verbesserung der Führungsfähigkeiten von unteren Führungskräften verschiedenster Funktionsbereiche eines international agierenden Autoverleihers; und

(3) ein aus sechs Modulen mit jeweils 4 Stunden Umfang bestehendes Programm zur Mitarbeiterführung, das innerhalb eines Monats umgesetzt wurde und an dem – in der untersuchten Pilotierungsphase – insgesamt 16 untere Führungskräfte in einer Produktionsstätte eines Anbieters von Telekommunikations- und Netzwerkausrüstung teilnahmen.

Die Kosten der drei analysierten Programme (inklusive extern durchgeführte Evaluation) liegen bei US$ 580‘000, US$ 160‘000 und 80‘000; der ermittelte ROI liegt bei 221%, 105% und 581%.

Insgesamt bietet das Buch wenig Neues gegenüber „The value of learning“ von 2007, ist aber konsequent auf die Diskussionen im Bereich der Führungskräfteentwicklung ausgerichtet. Die drei Fallstudien stellen eine gute Ergänzung zu den Ausführungen im ersten Teil des Buches dar und demonstrieren die jeweils fallspezifische Umsetzung der Methodologie.

——————————-

Phillips, J., Phillips, P., & Ray, R. (2012). Measuring Leadership Development: Quantify Your Program’s Impact and ROI on Organizational Performance. New York: McGraw-Hill.

Weitere Publikationen dieser Autoren:

Pulliam Phillips, P., & Phillips, J. J. (2007). The value of learning. How organisations capture value and ROI and translate it into support, improvement and funds. San Francisco: Pfeiffer.

Pulliam Phillips, P., & Phillips, J. J. (2007). Proving the value of HR. ROI case studies. Birmingham, AL: ROI Institute.